Inteligência artificial analógica é demonstrada em redes neurais físicas

Redação do Site Inovação Tecnológica - 22/12/2023

[Imagem: LWE/EPFL]

IA com sistemas físicos

Embora já faça parte do senso comum pensar no avanço tecnológico em termos da mudança do analógico para o digital, o consumo de energia descomunal dos computadores eletrônicos digitais está forçando cientistas e engenheiros a buscarem alternativas.

Esse movimento da eletrônica digital para a computação analógica agora chegou à inteligência artificial (IA), que tem sido um dos vilões do consumo de energia, já que aplicações como os grandes modelos de linguagem (ChatGPT, Bard e equivalentes) ocupam centros de dados que gastam tanta eletricidade quanto cidades inteiras.

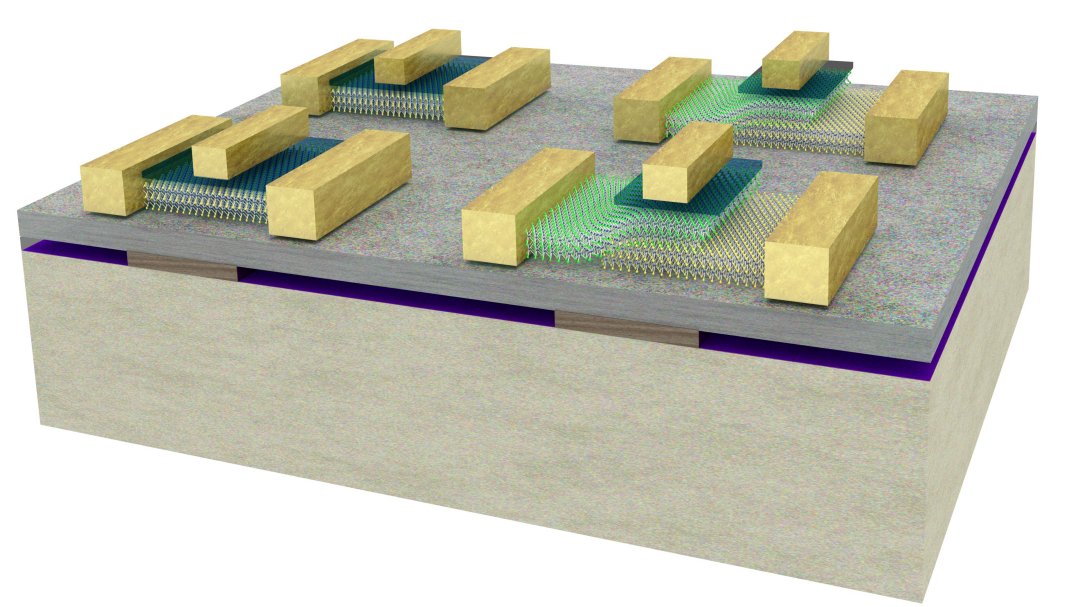

Pesquisadores desenvolveram agora um algoritmo para treinar uma rede neural analógica com a mesma precisão de uma digital, permitindo o desenvolvimento de alternativas mais eficientes para hardwares de aprendizado profundo, que consomem muita energia para treinar os sistemas de IA. Os resultados mostraram melhorias em todos os quesitos, incluindo velocidade, robustez e consumo de energia.

E trata-se de um algoritmo para treinar sistemas físicos, o que significa que ele pode ser aplicado a múltiplas plataformas de hardware - a plataforma mais usada na computação analógica atualmente são os processadores de luz, ou processadores fotônicos.

"Nós testamos com sucesso nosso algoritmo de treinamento em três sistemas físicos baseados em ondas que usam ondas sonoras, ondas de luz e micro-ondas para transportar informações, em vez de elétrons. Mas nossa abordagem versátil pode ser usada para treinar qualquer sistema físico," detalhou Ali Momeni, da Escola Politécnica Federal de Lausanne (EPFL), na Suíça.

[Imagem: Yuval Meir et al. - 10.1038/s41598-023-32559-8]

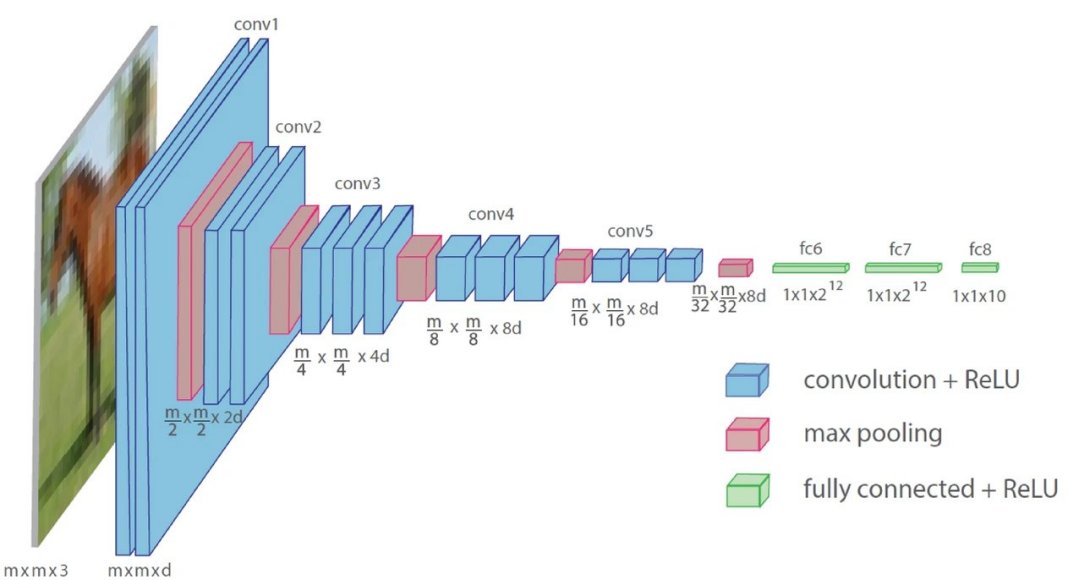

Uma abordagem "biologicamente mais plausível"

Treinar uma rede neural diz respeito a ajudar os sistemas a aprenderem a gerar valores ideais de parâmetros para uma tarefa como o reconhecimento de uma imagem ou de um trecho de fala. Tradicionalmente, isto envolve duas etapas: Uma passagem direta, onde os dados são enviados pela rede e uma função de erro é calculada com base na saída; e uma passagem para trás (conhecida como retropropagação), onde é calculado um gradiente da função de erro em relação a todos os parâmetros da rede.

Repetindo isso múltiplas vezes - o que os cientistas da computação chamam de múltiplas iterações - o sistema se atualiza com base nesses dois cálculos para retornar valores cada vez mais precisos.

Mas há um problema ou dois com isso: Além de consumir muita energia, por ser computacionalmente intensiva a retropropagação é pouco adequada para sistemas físicos. Na verdade, o treinamento de sistemas físicos geralmente requer um gêmeo digital para essa etapa, o que é ineficiente e acarreta o risco de uma incompatibilidade entre a simulação e a realidade.

A ideia de Momeni e seus colegas é substituir a etapa de retropropagação por uma segunda passagem direta através do sistema físico, atualizando cada camada da rede localmente. Além de diminuir o consumo de energia e eliminar a necessidade de um gêmeo digital, esse método reflete melhor o aprendizado humano.

"A estrutura das redes neurais é inspirada no cérebro, mas é improvável que o cérebro aprenda através da retropropagação," explicou Momeni. "A ideia aqui é que, se treinarmos cada camada física localmente, poderemos usar nosso sistema físico real, em vez de primeiro construir um modelo digital dele. Portanto, desenvolvemos uma abordagem que é biologicamente mais plausível."

[Imagem: EPFL]

Um futuro analógico nos espera?

Os pesquisadores usaram seu algoritmo físico de aprendizagem local, que eles batizaram de PhyLL (Physical Local Learning), para treinar sistemas experimentais acústicos e de micro-ondas e um sistema óptico modelado para classificar dados como sons de vogais e imagens.

Além de mostrar precisão comparável ao treinamento baseado em retropropagação, o método mostrou-se robusto e adaptável mesmo em sistemas expostos a perturbações externas imprevisíveis - ele foi sempre comparado aos métodos estado da arte de IA.

Embora esta abordagem represente o primeiro treinamento livre de retropropagação de redes neurais físicas profundas, algumas atualizações digitais dos parâmetros ainda são necessárias. "É uma abordagem de treinamento híbrida, mas nosso objetivo é diminuir ao máximo a computação digital," disse Momeni.

Como próximo passo, a equipe pretende implementar seu algoritmo em um sistema fotônico de pequena escala, com o objetivo de aumentar a escalabilidade da rede. "Em nossos experimentos, usamos redes neurais com até 10 camadas, mas será que ainda funcionaria com 100 camadas com bilhões de parâmetros? Este é o próximo passo e exigirá a superação das limitações técnicas dos sistemas físicos," concluiu o pesquisador.

Artigo: Backpropagation-free training of deep physical neural networks

Autores: Ali Momeni, Babak Rahmani, Matthieu Malléjac, Philipp del Hougne, Romain Fleury

Revista: Science

DOI: 10.1126/science.adi8474

Sonar cria avatar em tempo real com seu olhar e expressão facial

Além do mundo 3D: Dimensões sintéticas abrem novos caminhos para a luz

Hardware líquido: Computação é feita com sinapses iônicas

Computação analógica resolve equações complexas, rumo ao mercado

Componentes ópticos macios fazem computação com luz

IA na velocidade da luz feita com processador fotônico de silício

Reator de fusão nuclear supera dois obstáculos operacionais importantes

Descoberto maior buraco negro estelar da Via Láctea

Descobertas evidências mais antigas do campo magnético da Terra

Oureno: Criado um "grafeno de ouro"

Revolucionário: Luz gera magnetismo em material isolante

Célula solar atinge 190% de eficiência quântica

Metafluidos: Vêm aí os líquidos inteligentes

Criados bits quânticos que mantém dados à temperatura ambiente

Melhor rota para naves espaciais é traçada com teoria dos nós

Intel apresenta maior computador neuromórfico inspirado no cérebro

Todos os direitos reservados.

É proibida a reprodução total ou parcial, por qualquer meio, sem prévia autorização por escrito.