IA já está aprendendo sem que precisemos lhe ensinar

Com informações do MIT - 10/02/2023

[Imagem: Jose-Luis Olivares/MIT]

Aprendizagem no contexto

Grandes modelos de linguagem, como o GPT-3 da OpenAI, usado na estrela do momento, o ChatGPT, são redes neurais massivas que podem gerar texto semelhante ao criado pelos seres humanos, de poesia a códigos de programação. Treinados usando dados da internet, esses modelos de aprendizado de máquina pegam um pequeno texto de entrada e então preveem o texto que provavelmente virá a seguir.

Mas isso não é tudo o que esses modelos podem fazer. Pesquisadores estão explorando um fenômeno curioso, conhecido como aprendizagem no contexto - ou aprendizagem contextual - no qual um grande modelo de linguagem aprende a realizar uma tarefa depois de ver apenas alguns exemplos - apesar do fato de não ter sido treinado para essa tarefa.

Por exemplo, alguém pode alimentar o modelo com várias sentenças de exemplo e seus sentimentos (positivos ou negativos), então solicitar uma nova sentença, e o modelo pode fornecer o sentimento correto.

Normalmente, um modelo de aprendizado de máquina como o GPT-3 precisaria ser treinado novamente com novos dados para essa nova tarefa. Durante esse processo de treinamento, o modelo atualiza seus parâmetros à medida que processa novas informações para aprender a tarefa. Mas, com o aprendizado no contexto, os parâmetros do modelo não são atualizados, então parece que o modelo aprende uma nova tarefa sem passar pelo processo de aprendizado.

Cientistas do MIT, Google Research e Universidade de Stanford estão se esforçando pra desvendar esse mistério. Para isso, eles começaram estudando modelos menores, mas muito semelhantes aos grandes modelos de linguagem, para ver como eles podem aprender sem atualizar os parâmetros.

[Imagem: CC0 Creative Commons]

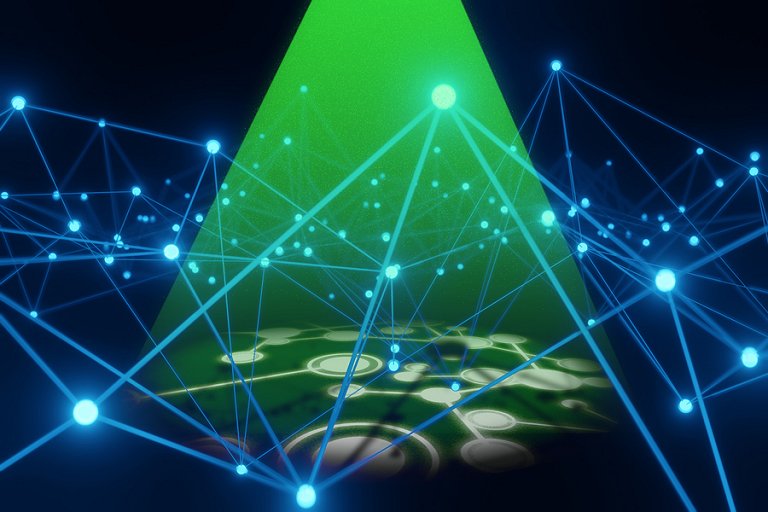

Um modelo filhote dentro de um modelo maior

Os resultados obtidos pela equipe mostram que esses modelos massivos de redes neurais são capazes de conter modelos lineares menores e mais simples enterrados dentro deles. O modelo grande consegue então implementar um algoritmo de aprendizado simples para treinar esse modelo linear menor para concluir uma nova tarefa, usando apenas as informações já contidas no modelo maior - seus parâmetros permanecem fixos.

Este é um passo importante para entender os mecanismos por trás do aprendizado no contexto, abrindo as portas para mais exploração em torno dos algoritmos de aprendizado que esses grandes modelos podem implementar, ressalta Ekin Akyurek, principal autor de um artigo que detalha os primeiros resultados desta pesquisa. Com uma melhor compreensão do aprendizado no contexto, os pesquisadores poderão permitir que os modelos concluam novas tarefas sem a necessidade de um novo treinamento dispendioso.

"Normalmente, se você deseja fazer uma sintonia fina desses modelos, precisa coletar dados específicos do domínio e fazer alguma engenharia complexa. Mas agora podemos apenas alimentá-lo com uma entrada, cinco exemplos, e ele realiza o que queremos. Então, o aprendizado de contexto é um fenômeno bastante empolgante," disse Akyurek.

Na comunidade de pesquisa de aprendizado de máquina, muitos cientistas passaram a acreditar que grandes modelos de linguagem podem realizar aprendizado no contexto devido à forma como são treinados, mas o assunto ainda dividia opiniões.

Por exemplo, o GPT-3 tem centenas de bilhões de parâmetros e foi treinado lendo grandes trechos de texto na internet, desde artigos da Wikipédia até postagens do Reddit. Portanto, quando alguém mostra ao modelo exemplos de uma nova tarefa, ele provavelmente já havia visto algo muito semelhante porque seu conjunto de dados de treinamento incluía textos de bilhões de sites. Ele repete os padrões vistos durante o treinamento, em vez de aprender a realizar novas tarefas.

[Imagem: CC0 Creative Commons]

Aprendendo a aprender

Para testar a hipótese de modelos menores de aprendizado de máquina emergindo dentro desses grandes modelos, os pesquisadores usaram um modelo de rede neural conhecido como "transformador", ou metamórfico, que tem a mesma arquitetura do GPT-3, mas foi treinado especificamente para aprendizado no contexto.

Ao explorar a arquitetura desse metamorfo, eles provaram matematicamente que ele pode escrever um modelo linear dentro de seus estados ocultos. Uma rede neural é composta por muitas camadas de nós interconectados que processam dados. Os estados ocultos são as camadas entre as camadas de entrada e saída.

Suas avaliações matemáticas mostram que esse modelo linear está escrito em algum lugar nas primeiras camadas do transformador. O transformador pode então atualizar o modelo linear implementando algoritmos de aprendizado simples.

Em essência, o modelo simula e treina uma versão menor de si mesmo.

"Portanto, minha esperança é que isso mude a visão de algumas pessoas sobre a aprendizagem no contexto. Esses modelos não são tão estúpidos quanto as pessoas pensam. Eles não apenas memorizam essas tarefas. Eles podem aprender novas tarefas, e mostramos como isso pode ser feito," concluiu Akyurek.

Artigo: What Learning Algorithm Is In-Context Learning? Investigations with Linear Models

Autores: Ekin Akyurek, Dale Schuurmans, Jacob Andreas, Tengyu Ma, Denny Zhou

DOI: 10.48550/arXiv.2211.15661

Link: https://arxiv.org/abs/2211.15661

Sonar cria avatar em tempo real com seu olhar e expressão facial

Além do mundo 3D: Dimensões sintéticas abrem novos caminhos para a luz

Hardware líquido: Computação é feita com sinapses iônicas

Computação analógica resolve equações complexas, rumo ao mercado

Componentes ópticos macios fazem computação com luz

IA na velocidade da luz feita com processador fotônico de silício

Descoberto maior buraco negro estelar da Via Láctea

Descobertas evidências mais antigas do campo magnético da Terra

Oureno: Criado um "grafeno de ouro"

Célula solar atinge 190% de eficiência quântica

Único no mundo, chip que funciona com luz é lançado industrialmente

Metafluidos: Vêm aí os líquidos inteligentes

Criados bits quânticos que mantém dados à temperatura ambiente

Intel apresenta maior computador neuromórfico inspirado no cérebro

Bateria de íons de sódio recarrega em segundos

Melhor rota para naves espaciais é traçada com teoria dos nós

Todos os direitos reservados.

É proibida a reprodução total ou parcial, por qualquer meio, sem prévia autorização por escrito.